Quando os sistemas inteligentes decidem por nós, eles decidem como nós? Há cada vez mais software e hardware a operar autonomamente para substituir os humanos. Têm capacidade de aprendizagem e autorização para tomar decisões. Mas cabe-nos garantir que as escolhas das máquinas estão alinhadas com a moral humana.

Elaine Herzberg, de 49 anos, ia atravessar uma estrada à noite, em Tempe, no Arizona (EUA), no dia 18 de março de 2018, pelas 22 horas, quando foi atropelada por um Volvo XC90 cinzento. Acabou por morrer no hospital e, ao mesmo tempo, o seu nome entrou para a história por razões peculiares: não ia ninguém a guiar o carro que a matou. O automóvel era um veículo de testes da Uber que seguia em modo de condução autónoma havia cerca de 20 minutos. A motorista de segurança ia a assistir ao programa “The Voice” no telemóvel aquando do impacto. Não sabemos se um humano ao volante teria feito melhor do que o carro autónomo. Mas sabemos que é muito difícil responder a esta pergunta: quem matou Elaine Herzberg? Sabemos também que estes cenários e estas dúvidas serão cada vez mais frequentes no futuro. Com o avanço dos sistemas de inteligência artificial (IA), as máquinas fazem cada vez mais atividades por nós. E essa execução já não se limita, como antigamente, ao cumprimento das nossas instruções: dotadas de capacidade de aprendizagem própria, as máquinas e sistemas inteligentes são desenhados para tomar decisões, sem nos consultarem. E isso levanta muitas questões: que autonomia lhes devemos dar? Conseguiremos programá-los para tomarem decisões morais e éticas? Temos forma de prever o impacto social desses sistemas? De quem é a responsabilidade quando tomarem más decisões? Temos mecanismos para detetar e fiscalizar sistemas concebidos com maus propósitos?

Hoje, ainda não há uma resposta satisfatória para nenhuma dessas perguntas. “Um dos dilemas éticos fundamentais com que nos confrontamos hoje, no que diz respeito aos sistemas de IA, é a incapacidade de não só prever o desenvolvimento que esse processo de “aprendizagem” poderá ter, mas, sobretudo a incapacidade de responsabilização perante o erro que daí possa resultar”, defende Luís Lóia, professor da Universidade Católica Portuguesa, coordenador do curso de licenciatura em Filosofia e coordenador-executivo da Formação Ética da Inteligência Artificial. “Se o fator humano se pode encontrar no princípio da criação dos sistemas de inteligência artificial, ele desaparece aquando do seu desenvolvimento e não controla os seus fins.”

E, no entanto, os problemas éticos que levantam os sistemas de IA não são de amanhã, são de agora. As máquinas já tomam decisões por nós. “O principal problema com que nos confrontamos hoje é a capacidade de esses sistemas interferirem nas escolhas humanas e invadirem a sua privacidade”, alerta Luís Lóia. “Considerando que nas redes sociais a informação que nos é prestada ou que nos está mais acessível é filtrada pelo cálculo das pesquisas que fizemos e pela interação que mantemos com essa mesma informação, então, ficamos, inadvertidamente, privados de muita outra informação que pode ser muito significativa”, esclarece.

De resto, salienta o professor, se uma das indústrias em maior desenvolvimento nos nossos dias é o negócio ao acesso e à partilha de dados, é precisamente porque “esse tipo de negócio tem como objetivo fundamental desenvolver e aumentar as capacidades dos sistemas de IA com vista à sua futura comercialização. Não é por acaso que os sistemas de direito do Mundo ocidental se têm vindo a preocupar, cada vez mais, com a proteção de dados, criando leis que nela se foquem”, resume.

Regular, auditar e fiscalizar

Por todo o Mundo estão a ser criados documentos que possam dar resposta aos desafios éticos que a IA traz. A União Europeia publicou este ano o AI ACT – um documento para promover a sua regulamentação e limitar os potenciais impactos negativos – e a UNESCO apresentou também a sua Recomendação sobre a Ética da Inteligência Artificial – uma proposta das primeiras diretrizes mundiais.

Luís Moniz Pereira foi uma das pessoas que colaboraram no documento com 134 artigos da UNESCO. Professor catedrático emérito da Universidade Nova de Lisboa, é uma das pessoas que há mais tempo pensa e escreve sobre IA em Portugal. Foi o presidente fundador da Associação Portuguesa para a Inteligência Artificial, em 1984, e tem vasta obra sobre o tema. Garante que “é indispensável, a tempo e horas, formular e implementar um novo contrato social, a fim de se evitar uma revolução sem precedentes, com consequências imprevisíveis”. Até ver, avisa, as aplicações da IA estão a ser feitas “sem obediência a quaisquer regras legais e standards de controlo específicos”. Refere que deve haver o cuidado de “não regulamentar em excesso a fase inicial de exploração criativa”, mas também alerta para o facto de que “o desejo de chegar primeiro ao mercado induz a tentação de poupar recursos e tempo, dando menos atenção à segurança e à ética”.

Estas preocupações éticas têm de começar na conceção. “Antes de se desenvolver ou aplicar um sistema inteligente, deve ter-se em atenção os impactos que este pode ter na sociedade”, explica Alípio Jorge, coordenador do Laboratório de Inteligência Artificial e de Apoio à Decisão do INESC TEC e diretor do Departamento de Ciência de Computadores, da Faculdade de Ciências da Universidade do Porto. Um exemplo: a par dos muitos impactos positivos que estas tecnologias geram – e vão continuar a gerar -, a OCDE estima também que, em 2030, o desemprego adicional provocado pela IA será de 14%.

Dois dos conceitos centrais para promover a segurança e a ética em quase todos os documentos sobre IA são a transparência e a auditabilidade. “As técnicas de IA e de Aprendizagem Computacional atualmente com mais sucesso baseiam-se em modelos matemáticos opacos”, considera Alípio Jorge. Ou seja, eles até podem produzir boas decisões, mas ninguém sabe como ou porquê. “Não é possível ao utilizador, ou mesmo a um especialista do domínio, entender a razão daquela decisão. A falta de transparência desses modelos é um problema em muitas áreas, como por exemplo no diagnóstico médico ou na atribuição de crédito.” O especialista sustenta que são necessários novos algoritmos – ou a modificação dos existentes – para que estes consigam explicar as decisões que tomam. E exemplifica, precisamente, com o caso de um atropelamento por um veículo autónomo. “É importante perceber qual foi a sequência de inputs e de decisões tomadas que levaram a um desfecho trágico ou indesejável. Tal como aconteceria com um condutor humano, teremos de ter meios para questionar o sistema inteligente sobre o que se passou. Para isso, o sistema inteligente deve ser desenvolvido de forma a que as suas decisões e ações sejam rastreáveis e auditáveis.”

Essa transparência também deve ser tida em conta na interação com os humanos. Uma das leis no âmbito da IA aprovada em 2018, no estado da Califórnia (EUA), define que um chatbot – um software que “conversa” com um utilizador de um site – tem a obrigatoriedade de se identificar como tal, de forma que as pessoas não pensem que estão a trocar mensagens escritas com outro humano.

A moral da máquina ou a moral humana?

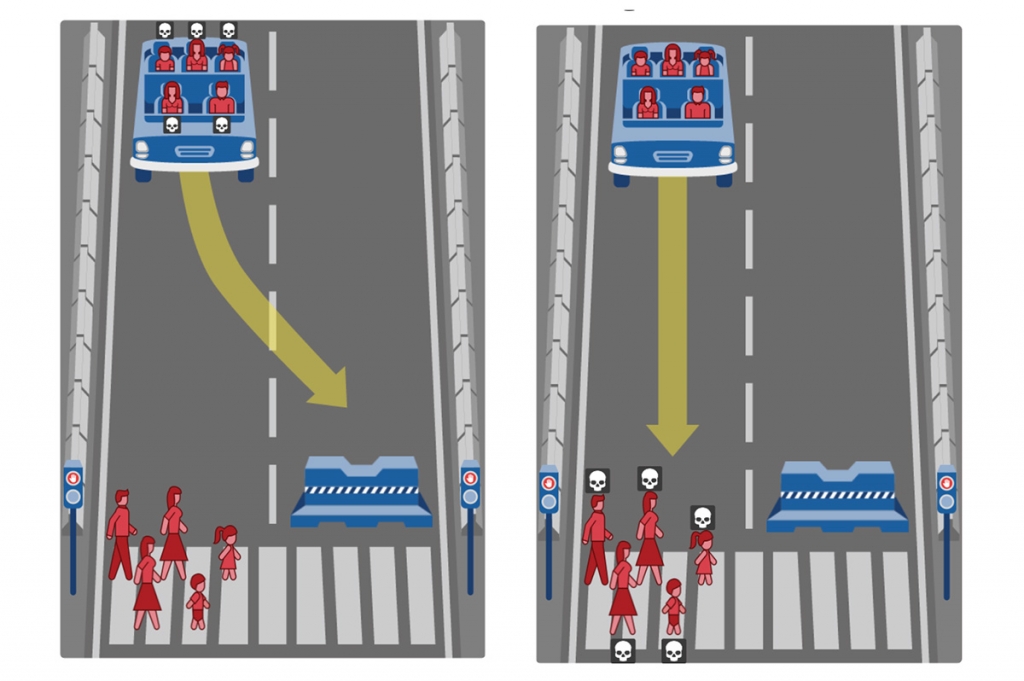

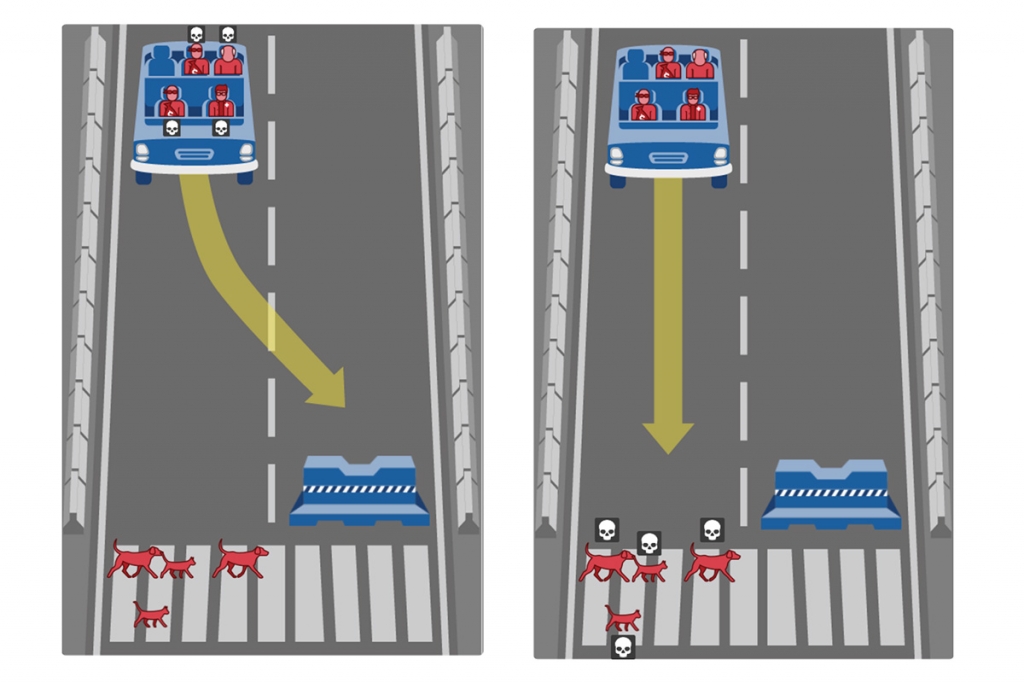

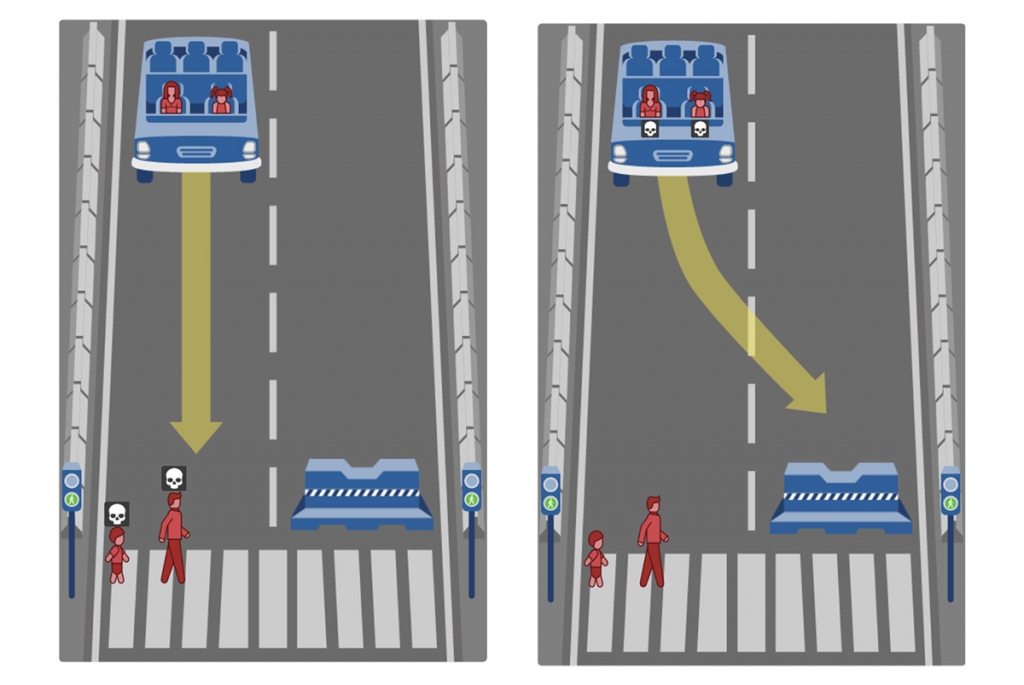

No livro “Máquinas éticas – da moral da máquina à maquinaria da moral” (Nova FCT Editorial, 2020), Luís Moniz Pereira apresenta aquilo a que chama “o carrossel das máquinas éticas”, em que sintetiza as seis principais questões que temos de ter em mente na abordagem à IA, mostrando como este é um assunto que extravasa em muito as questões tecnológicas e vive paredes-meias com a psicologia, a filosofia, o direito, a antropologia e a economia.

A primeira questão talvez seja esta: queremos máquinas alinhadas com a ética humana, mas sabemos nós descrever os nossos próprios valores morais? “Não, não o sabemos fazer. Nem sequer enunciar de modo preciso as nossas escalas de valores, as quais variam culturalmente, mesmo em vocabulário”, responde Moniz Pereira. Mas o problema não é apenas filosófico, de momento, é também técnico: além de não os sabermos enunciar, não os sabemos programar. Apesar de ser possível dotar programas de computador de capacidades morais, como sentir um sucedâneo da culpa – e Moniz Pereira fá-lo a título experimental há mais de 15 anos – , o especialista refere que “as próprias linguagens de programação não contêm ainda os conceitos e as construções necessários para tal”. De resto, realça que, mesmo em aspetos operacionais, relacionados com segurança, os resultados podem dar para o torto. “Atente-se no caso do Boeing-737 Max, em que a incúria levou à realização de um software que se sobrepunha à vontade dos pilotos e caíram por isso dois aviões”, recorda.

Também Luís Lóia tem muitas preocupações com o futuro: “As implicações que os sistemas de inteligência artificial terão no mundo do trabalho, dispensando a mão de obra humana; na educação, podendo vir a tornar a escola numa base de recursos virtuais e de aferição de competências por meios eletrónicos; e, por fim, as suas aplicações nos sistemas de defesa dos países, nomeadamente em caso de conflito, com o eventual sacrifício de inúmeros inocentes, como já estamos a assistir, trocando-se a prudência pela eficiência”.

“A ética não é passível de ser reduzida a qualquer outra substância que não seja humana”, conclui Luís Lóia. Essa é talvez uma das principais lições do acidente que matou Elaine Herzberg, em 2018. A investigação do acidente, feita pelo Conselho Nacional de Segurança nos Transportes, distribuiu responsabilidades por todos: aos responsáveis da Uber, porque o software foi mal concebido, à condutora de segurança do veículo autónomo, por ir a olhar para o telemóvel, ao governador do Arizona, por políticas públicas de salvaguarda insuficientes, e até à vítima, por estar a atravessar uma estrada onde não podia. O carro inteligente ficou de fora. O que matou Elaine Herzberg não foi um erro tecnológico, mas vários erros humanos.